Mohamed Hassan

VP Design & CX

Vor Kurzem haben wir am Chatbot Africa & Conversational AI Summit 2021 teilgenommen und dort einen Vortrag zum Thema „Contextual voice experiences“ gehalten. Im folgenden Blogpost wollen wir uns diesem Thema noch einmal genauer widmen.

Die Teilnahmerzahlen und das Interesse an dem Event waren überraschend hoch und wir fanden es sehr spannend, uns mit Voice-Expert*innen aus dieser Region auszutauschen. Chatbots und virtuelle Assistenten sind momentan definitiv auf dem Vormarsch: Sie haben einen großen Einfluss auf Millionen von Unternehmen und begleiten uns im Alltag auf Smartphones und Smart Speakern.

Das Herzstück der Konferenz waren eindeutig die Vorträge, die sich mit den Herausforderungen der Konnektivität, Sprachunterstützung und Lokalisierung beschäftigten. Wir waren zudem positiv überrascht davon, wie häufig das Thema Inklusivität in den Vorträgen angesprochen wurde. Ein weiteres zentrales Thema war KI-Diversität, eine der aktuell größten und dringendsten Herausforderungen im Tech-Bereich, wie auch der Stanford AI Trends Report 2021 bestätigt.

Wenn wir intelligente Assistenten bauen wollen, müssen wir vor allem das allgemeine Verständnisproblem lösen, indem wir jeden Einzelnen einbeziehen. Und das bedeutet wirklich jeden Einzelnen. Es ist aktuell immer noch eine große Herausforderung für Sprachassistenten, zusätzliche Sprachen, Dialekte oder gar kulturelle Konzepte mit einzubeziehen.

Obwohl Sprachassistenten heute bereits in manchen Sprachen korrekt sprechen können, ist es ihnen immer noch ein Unmögliches uns Menschen vollkommen zu verstehen, dies betreffend auch Menschen mit einer Behinderung oder Kinder mit einer vereinfachten Ausdrucksweise. Künstliche Intelligenzen haben diese Herausforderung im Sprachverständnis auch bereits seit einiger Zeit.

Oder vielleicht fehlt ihnen auch eine bestimmte Wissensebene, wie diese Facebook-Studie nahelegt:

„Wenn KI-Systeme ein tieferes und detaillierteres Verständnis der Realität erlangen können, das über das hinausgeht, was wir ihnen antrainieren, werden sie noch nützlicher sein und KI letztendlich noch näher an das Niveau menschlicher Intelligenz heranbringen.“

Da Menschen über Sprache kommunizieren, sollte die Lernkurve für die Nutzung von Sprachassistenten nicht so lang sein. Wenn Sie mit einem Sprachassistenten sprechen, werden Ihnen womöglich sofort seine Grenzen bewusst werden. Kann es den Unterschied verstehen zwischen „hier“ und „dort“ erkennen? Was bedeutet das räumlich? Gibt es da einen Zusammenhang zwischen beidem?

Letztendlich können wir nicht alles auf der Welt mit einem eindeutigen Etikett versehen. Verstand und die Fähigkeit, Zusammenhänge zu erkennen, sind Dinge, die auch ein intelligenter Sprachassistent benötigt. Unser Verstand hilft uns Menschen, neue Aufgaben mithilfe von bereits angelegten mentalen Modellen zu erledigen, ohne dass wir dafür viel zusätzliche Übung bräuchten. Denken wir nur einmal darüber nach, wozu ein Kind in der Lage ist und im Vergleich dazu ein Erwachsener. Aus diesem Bereich kommt der Begriff „kontextbezogen“ in Bezug auf Voice Experiences. Ich persönlich beschäftige mich mit diesem Thema im Rahmen meines Promotionsstudiums.

Werfen wir nun einen Blick auf die bereits verfügbaren Funktionen, die Sprachassistenten helfen, intelligenter zu sein und Zusammenhänge zu verstehen.

Derzeit können die auf dem Markt erhältlichen Sprachassistenten die folgenden Daten nutzen:

Der Konversationsverlauf hilft nicht nur beim Training, sondern auch bei der Entscheidung darüber, was der User wahrscheinlich als nächstes fragen wird.

Das Benutzerprofil hilft bei der Anpassung von Dialogen an das Alter und die persönlichen Präferenzen des Users.

Diese Angaben helfen dabei, die Proaktivität der Sprachassistenten zu verbessern sowie die Nutzerzufriedenheit zu erhöhen und eine langfristige Nutzung sicherzustellen.

Diese Daten helfen dabei, die individuellen Nutzungszahlen und die Anzahl der Drop-Outs zu verstehen.

Diese Information hilft bei der Entscheidung, auf welchen (anderen) Geräten oder Services die Experience gestartet bzw. fortgesetzt werden soll.

Sie hilft dabei, die Dialoge je nach Stimmung und Emotionen des Users anzupassen und sogar die Absicht des Users zu verstehen. (So ist es z.B. ein Unterschied, ob ich „Ich brauche Papa“ in einem ruhigen, tiefen Ton sage oder in einem hohen, lauten Ton. Letzteres könnte beispielsweise auf eine gewisse Dringlichkeit hinweisen.)

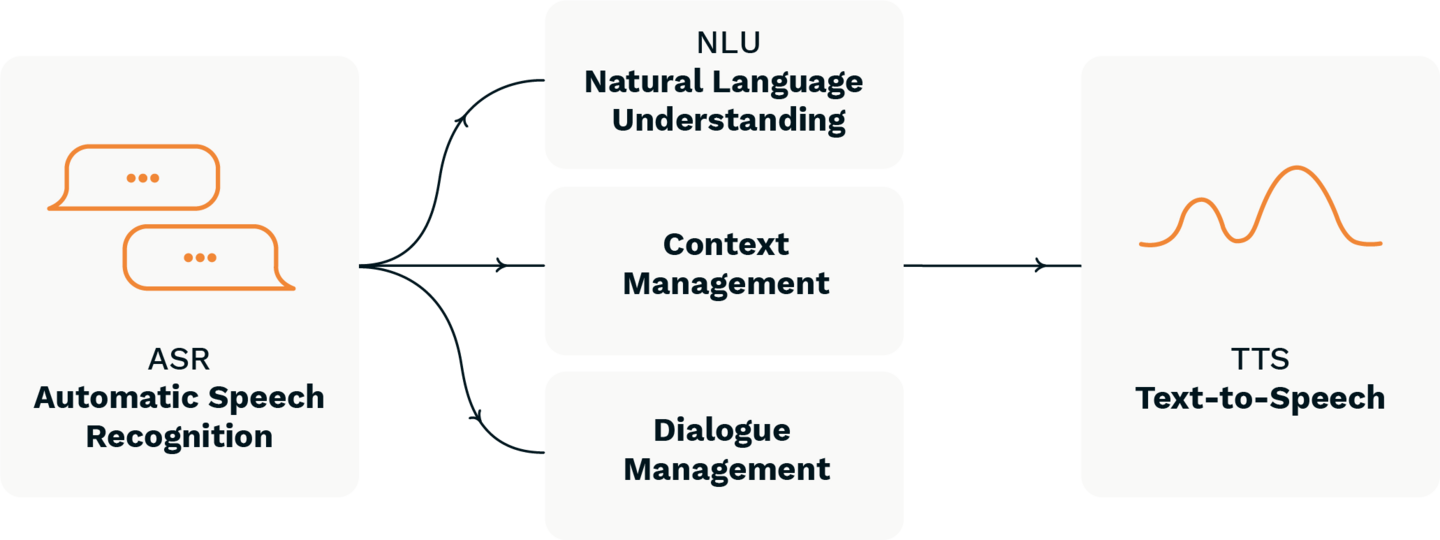

Dennoch müssen wir weiterhin auf den bereits bestehenden Funktionen aufbauen. Insbesondere benötigen Sprachassistenten technologische Komponenten, die für eine gewisse Verstand-Fähigkeit oder für das Kontextmanagement sorgen.

Die aktuelle KI-Forschung ist sehr daran interessiert, den menschlichen Verstand nachzubauen und der KI so die Möglichkeit zu geben, selbstständig Konzepte erlernen zu können. Selbstgesteuertes Lernen ist der zentrale Aspekt, um eine Kontextmanagement-Komponente für Voice-Technologie zu erreichen.

in entscheidender Vorteil dieser Komponente ist, dass der Sprachassistent den Zusammenhang zu dem, was vorher im Konversationsverlauf gesagt wurde, verstehen und daraus sinnvolle Schlussfolgerungen darüber ziehen könnte, was die tatsächliche Absicht hinter einer neuen User-Anfrage ist. Mit anderen Worten: „Ich brauche Papa“ bedeutet in unserem Fall „Bitte sag Papa, dass er zu mir kommen soll“ (basierend auf den wenigen Sekunden, die wir im Video gesehen haben).

Die Beziehung zwischen den Personen oder Objekten in unserem Zuhause ist sehr wichtig, um die Entscheidungsfähigkeit des Sprachassistenten und dadurch auch seine Antworten zu verbessern.

Diese Beziehungen helfen dem Assistenten dabei, den Unterschied zwischen „hier“ und „da drüben“ oder „drinnen“ und „draußen“ zu verstehen, oder sogar die Bedeutung der Orte „Wohnzimmer“ und „Schlafzimmer“. So könnte der Sprachassistent z.B. verstehen, zu welchen Tageszeiten diese Räume üblicherweise genutzt werden und für welche Aktivitäten, oder welche Möbel und Geräte sich in diesen Räumen befinden.

Eine Frage wie z.B. „Macht es Sinn, um 3 Uhr nachts alle Lichter im Schlafzimmer einzuschalten, während Leute in dem Raum schlafen?“ könnte ein Sprachassistent leicht beantworten, solange er alle erforderlichen Parameter kennt.

Mithilfe einer so starken Verstand-Komponente könnte es in Zukunft einen Sprachassistenten geben, der uns tatsächlich unterstützen kann und vielleicht sogar Intelligenz besitzt, die weit über die heute üblichen Sprachassistenten, die nur auf unsere Befehle reagieren, hinausgeht.

Ein Assistent, der darauf wartet, dass man ihn anspricht und ihm befiehlt, die Absichten des direkten Users zu erfüllen. Eine Konversation mit diesem Assistenten kann zu einem Dialog führen. (Wenn Sie ihn nach einem Kochrezept fragen, wird er Ihnen ein Kochrezept zeigen.)

Ein Assistent, der auf Anfrage Empfehlungen geben kann, um direkte und indirekte Absichten des Users zu erfüllen. Eine Konversation mit diesem Assistenten kann zu einem Dialog führen. (Wenn Sie ihn nach einem Kochrezept fragen, zeigt er Ihnen ein Kochrezept und schlägt Ihnen vor, ggf. noch fehlende Zutaten einzukaufen.)

Ein Assistent, der mit dem User zusammenarbeiten kann, um Absichten zu formulieren und diese dann im kooperativen Stil zu erfüllen. Eine Konversation mit diesem Assistenten kann zu einem Dialog oder einer Diskussion führen. (Wenn Sie ihn nach einem Kochrezept fragen, zeigt er Ihnen ein Kochrezept, schlägt Ihnen vor, ggf. noch fehlende Zutaten einzukaufen, und unterstützt Sie anschließend beim Kochen, z.B. indem er den Ofen vorheizt.)

Ein Assistent, der sich selbst verwalten kann und eigenständig handelt, um die bereits vorprogrammierten Absichten des Users zu erfüllen. Eine Konversation mit diesem Assistenten kann zu einem Dialog, einer Diskussion oder einer echten Unterhaltung führen. (Wenn Sie ihn nach einem Kochrezept fragen, wird er selbstständig anfangen zu kochen.)

Bei genauerer Betrachtung stellen wir fest, dass das Kontextwissen im Verlauf zwischen Typ 1 und Typ 4 immer essenzieller wird. So lässt sich hier auch eine Korrelation zur Handlungsfähigkeit des jeweiligen Assistenten feststellen. Je weiter wir in der obigen Reihenfolge aufsteigen, desto mehr verlieren wir als User an Handlungsfähigkeit. Wir verlieren die Kontrolle über den Sprachassistenten. Ein Sprachassistent wird weit mehr als nur ein gehorsamer Helfer für uns, sondern wird vielleicht sogar wie wir. (Darüber werden wir in einem anderen Blog noch ausführlicher sprechen.)

Voice ist eine sehr persönliche Schnittstelle, die uns Menschen am nächsten kommt, da sie „unsere“ Sprache und damit unsere eigene Denkweise nutzt.

Der Design-Prozess für Voice Experiences muss also auch eine genaue Untersuchung des Kontexts beinhalten. Diese kontextuelle Untersuchung muss beispielsweise die physische Umwelt in Betracht ziehen (Holtzblatt et al., 1998). Dadurch können wir die Makro- und Mikroebene der Voice-Interaktion verstehen und die erforderlichen Kontextparameter definieren.

Der zweite Punkt ist eine technische Anforderung: Aktuelle Voice-Technologien und -Lösungen müssen ein Kontextmanagementsystem und eine Spracherkennung beinhalten, die von Entwickler*innen genutzt werden können. Um das zu ermöglichen, sind weitere Entwicklungen im Bereich der selbstlernenden Algorithmen zwingend notwendig.

Bei VUI.agency berücksichtigen wir immer auch kontextuelle Informationen, wenn wir Voice Experiences designen. Von der Anfragephase bis hin zum Test steht immer der Kontext und die Situation des Users im Mittelpunkt. Wir versuchen, die Grenzen der Technologie zu erweitern, um so einen noch intelligenteren und nützlicheren Sprachassistenten zu entwickeln.

Wenn wir einen intelligenten Assistenten haben wollen, der uns tatsächlich im Alltag hilft und uns als User nicht ständig nur frustriert, müssen wir zunehmend in neue, innovative Frameworks und Technologien investieren.

Unternehmen und Marken sollten versuchen, neue Wege für den Voice-Bereich zu erkunden und sich nicht nur auf die derzeitigen technischen Grenzen zu beschränken.

Schreiben Sie uns gerne, falls Sie mehr über das Thema Kontext im Voice-Bereich erfahren möchten.